Carlos B Fernández. Fueron dos intensas jornadas en las que cerca de cuarenta ponentes tuvieron oportunidad de compartir sus conocimientos y reflexiones con un nutrido grupo de expertos y profesionales del Derecho, la tecnología, la industria y la salud.

Lo que sigue pretende ser un reflejo, necesariamente sintético, pero con vocación de completez, sobre lo tratado en esos días.

PRESENTACIÓN Y APERTURA

En la apertura de la Jornada Julio Espiña Dapena, Director de Desarrollo Negocio de Administraciones Públicas de Minsait, señaló que estamos ante un escenario tecnológico y jurídico de gran complejidad, en el que el dato cobra una importancia creciente. Esta situación requiere de una intensa cooperación internacional para afrontar los retos que plantea tanto el rápido desarrollo de la IA (un tema en el que la Unión Europea se está quedando atrás), y una compleja regulación, de origen tanto europeo como nacional.

A continuación, Javier Palao Gil, Decano de la Facultat de Dret de la Universitat de València recordó como a lo largo de los últimos 30 años Internet ha transformado el mundo. Ahora cabe preguntarse cómo lo hará la IA y si lo hará para bien o para mal.

La IA no puede ser una herramienta de discriminación. Por ello, hay que afrontar los riesgos que plantea en relación con los sesgos de género, la exclusión de los países en vía de desarrollo y su amenaza al mundo del trabajo, aun asumiendo que también supone una oportunidad de mejor trabajo y remuneración. Y para lo lograrlo, es necesaria una concordia entre los estados, las administraciones y la academia.

En este contexto, Gabriel López Serrano, Director de Asuntos Regulatorios para Microsoft Ibérica, destacó que España está frente a una gran oportunidad para situarse en la vanguardia del desarrollo tecnológico, porque cuenta con cuatro elementos diferenciadores: una infraestructura de comunicaciones de primer nivel, que genera un importante efecto tractor para data centers y la industria de semiconductores; un elevado nivel de formación de sus profesionales, consecuencia de los más de 1.500 millones de euros invertidos, otra característica que genera un efecto atractivo para la industria. Destacó, igualmente, el compromiso con la sostenibilidad que supone el objetivo de “cero” huella de carbono para 2050 en la industria. Y apuntó, en cuarto lugar, a la privilegiada situación geopolítica de nuestro país, que, en su opinión, está ocupando el sitio que dejó el Reino Unido tras su salida de la Unión Europea, a lo que se suma su particular relación con el mundo hispanoparlante y también su cercanía a África y Oriente. Sumando todas estas características, y definidas las herramientas necesarias, concluyó López Serrano, puede considerarse que España cuenta con un gran futuro por delante. Ahora se trata de seguir el camino emprendido.

A continuación, Jesús Rubí, coordinador de la Unidad de Apoyo y Relaciones Institucionales de la Agencia Española de Protección de Datos (AEPD), planteó el intenso debate que se está produciendo en torno a la IA, centrado particularmente en los problemas que plantea su gobernanza y la protección de los datos personales utilizados para su entrenamiento y validación.

Lo esencial en este contexto, apuntó Rubí, es conocer las implicaciones prácticas que plantea la IA en los distintos ámbitos en los que puede aplicarse. Y para ello, en nuestro país disponemos de herramientas como las elaboradas por la AEPD, como la guía sobre requisitos en auditorías de tratamientos que incluyen Inteligencia Artificial o la guía sobre requisitos para

auditorías de tratamientos que incluyan IA, sin olvidar, a un nivel más estratégico, el contenido del Manifiesto del Dato elaborado por la Oficina del Dato, dependiente de la Secretaría de Estado de Digitalización e Inteligencia Artificial.

Siguió la presentación del encuentro a cargo de sus directores, los profesores Ricard Martínez y Rafael Marimón.

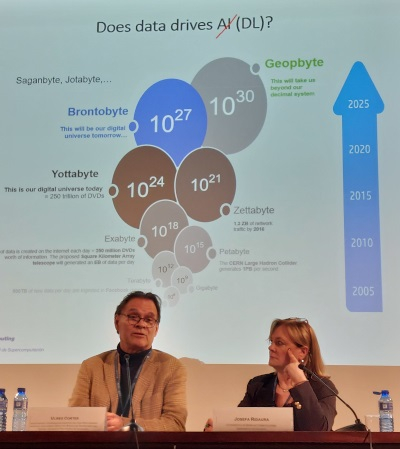

En su intervención, Ricard Martínez Martínez, puso el énfasis en la conveniencia, desde el punto de vista jurídico, de hacer una lectura de la IA en modo ingeniero, entendiéndola como una cadena de procesos que los juristas deben entender para poder gestionar los riesgos y aprovechar las oportunidades que plantea. Además, añadió, es fundamental tener en cuenta que para empezar cualquier proyecto de IA se necesitan datos. Sin ello, no hay IA, porque el camino lleva de los primeros a esta.

En esta situación, conviene utilizar el Derecho como un cauce para el desarrollo, no considerarlo como una barrera. Para ello es necesario un enfoque integrado que haga posible el desarrollo y aprovechamiento de la tecnología, considerando tanto sus implicaciones y exigencias técnicas como jurídicas. Una tarea en la que, subrayó, es fundamental el papel de los poderes públicos, pues solo desde lo público es posible afrontar con garantías un desarrollo integral de esta tecnología que no deje a nadie atrás.

Por su parte, Rafael Marimón Durá, Catedrático de Derecho Mercantil y Director de la Catedra Legaltech & Inteligencia Artificial Minsait - Universitat de València, señaló como objetivo de las sesiones que iban a desarrollarse la consideración de los retos jurídicos que plantea la relación entre la IA y la economía. Y ello teniendo en cuenta que el planteamiento jurídico plantea un reto a la economía, pues el riesgo jurídico es también un riesgo económico.

LA ESTRATEGIA EUROPEA DE IA

En su intervención en la primera mesa del encuentro, Juan Fernando López Aguilar, Presidente de la Comisión de Libertades Civiles, Justicia y Asuntos de Interior, del Parlamento Europeo, repasó las principales características del Reglamento de IA acordado entre los colegisladores de la Unión en la sesión de los trílogos que tuvo lugar entre el 6 y el 8 de diciembre de 2023.

Una completa regulación que nace con la vocación de ser duradera en el tiempo, para lo que incluye mecanismos de adaptación a la evolución tecnológica, ya que los legisladores tienen claro que, para cuando entre en vigor, ya podrá estar obsoleta en determinados aspectos. Pese a ello, sus autores consideran que seguirá teniendo pleno sentido.

Amplió esta visión del Reglamento europeo Miguel Valle del Olmo, de la Representación Permanente de España ante la UE para la Transformación Digital, quien comenzó recordando que las posturas de ambos colegisladores eran muy distintas en su inicio, pero que se desarrolló un buen proceso de entendimiento que permitió alcanzar un acuerdo bastante razonable.

En cuanto a los ejes de la norma, Valle destacó: Su defensa de la seguridad y la salud de las personas; la protección de los derechos fundamentales y la privacidad, en función de los riesgos que plantean estos sistemas y que los clasifica en sistemas prohibidos o de alto riesgo; unas obligaciones de transparencia para todos los sistemas considerados de alto riesgo, incluyendo la obligación de incluir una marca de agua (que puede ser visible o no) en los resultados de los sistemas generativos; el establecimiento de una serie de obligaciones para los usuarios (ahora desplegadores o deployers), de sistemas de alto riesgo y la regulación de los modelos fundacionales, alguno de los cuales pueden plantear riesgos sistémicos, para los que se establecen requisitos específicos sobre realización de unas pruebas previas.

En conjunto, explicó, se trata de una sistema adecuado y equilibrado, que establece obligaciones tanto ex ante como ex post y que ha sido resultado de un intenso debate consecuencia de conciliar los numerosos intereses concurrentes (estados, sociedad civil, políticos…).

A continuación aportó sus consideraciones sobre los aspectos económicos de la norma Javier Esteve Pradera, Coordinador de la Oficina del Datos de la Administración General del Estado, quien analizó los requerimientos para desarrollar una economía basada en el dato, es decir, una economía basada en el valor económico de todas las actividades que tienen que ver con la extracción de valor económico del dato, del cual la IA es un producto derivado. Un tema vital, por sus implicaciones jurídicas, políticas y económicas, que para 2025 se estima que alcance el billón de euros. La realidad es que quién gobierne este sector podrá ejercer un colonialismo tecnológico y económico y eso la UE quiere evitarlo.

Para conseguirlo, explicó, la herramienta necesaria son los espacios de datos, unos entornos para el desarrollo de la economía del dato dentro de un ecosistema o entorno para el desarrollo del negocio del dato.

ECONOMÍA DE LA IA. APUNTES PARA EL DEBATE

Continuó con el análisis económico de las implicaciones de la IA la segunda mesa de la mañana, en la que intervinieron Andrés Pedreño Muñoz, Catedrático de Economía Aplicada de la Universidad de Alicante; José María Lassalle, Profesor del IE Business School y José Manuel Pavía, Catedrático de métodos cuantitativos de Universitat de València, coordinados por

Carmen Montalba Ocaña, Profesora en el Departamento: Trabajo Social y Servicios Sociales de la Universitat de València.

El primer acercamiento al tema lo realizó el profesor José Manuel Pavía, quien explicó la particular relación que mantienen las personas con la IA, tal como se desprende de un estudio realizado por el BBVA sobre comportamiento ante esta tecnología.

Lo llamativo de sus resultados, explicó, es que la gente se dice preocupada por su privacidad, pero en la práctica, tanto en internet como, sobre todo, en las redes sociales, comparte todo tipo de datos. Es más, no modifica ese comportamiento aunque sepa que una IA va a estudiar su comportamiento, por mor de la denominada paradoja de la privacidad.

Por otra parte, Pavía advirtió de que la IA se está desarrollando principalmente con datos procedentes de los Estados Unidos y de China, y los valores que se contienen en esos datos se están trasladando a la IA resultante. Una circunstancia particularmente grave para Europa, pues esta va camino de una irrelevancia tecnológica y geopolítica, agravada por una regulación muy restrictiva. La consecuencia, según algunos estudios, es que para 2050, la economía europea será un 5% de la norteamericana, por tanto, sin capacidad de influencia.

Pasando al análisis del marco económico en el que se desarrolla la IA, Andrés Pedreño destacó que Europa tiene una situación complicada en este contexto, pues si bien las grandes tecnológicas se han desarrollado a lo largo de los últimos veinte años, Europa no cuenta con ninguna. La consecuencia ha sido que, desde 2008, Europa ha perdido ocho puntos de PIB, viéndose superada en la actualidad por los Estados Unidos y por China.

Ello evidencia que el modelo europeo es bastante obsoleto y muestra una alta dependencia tecnológica, que provoca que mucho del talento europeo se vaya a los Estados Unidos o el Reino Unido.

Por ello, reivindicó una economía europea digitalmente fuerte que justifique esa regulación. Europa tiene que tener su propia industria tecnológica, lo que implica asumir riesgos, pero también aprovechar sus estructuras y sus fuertes servicios públicos. Por ello necesitamos no simplemente una regulación, sino una regulación que sea eficiente, lo que implica, en buena medida, educación de la ciudadanía.

Cerró este bloque de intervenciones José María Lasalle, quien, recordando el mito de Prometeo, que puso de manifiesto que, frente al peligro de los excesos consecuencia de la soberbia de los hombres, se impone la necesidad de prudencia, señaló, de entrada, que el problema de raíz de la IA es que está gestionada por tecnólogos, que no saben de las claves que articulan el concepto de prudencia. Sobre todo, en un modelo como el de la modernidad científica en el que el conocimiento se hace equivalente al poder.

La consecuencia es que en la actualidad se tiende a olvidar que nos llevó un siglo alcanzar un pacto sobre las consecuencias de la revolución industrial basada en la máquina de vapor. Así, hoy la IA es el último reducto de la modernidad científica utópica y determinista.

La realidad, continuó, es que la IA no se puede controlar desde la limitación de la capacidad de poder, pero ni la universidad, ni la academia, ni los gobiernos están en esa cuestión. Se piensa que el control de los riesgos por medio de la ética puede limitar una voluntad de poder que no considera sus consecuencias últimas. Los humanistas “debemos ser la conciencia ética que introduzca la ética en la IA desde el principio, lo que exige, desde el principio, la presencia de humanistas en su desarrollo. En caso contrario, tendremos empresas más competitivas, pero también estados más controladores provistos de armas más letales.

RETOS JURÍDICOS PARA LA CONSTRUCCIÓN DE LOS ESPACIOS DE DATOS

Al fundamental tema de los espacios de datos necesarios para desarrollar la tecnología de IA, se dedicaron Teresa Martínez Sánchez, Jefa de Área de Innovación de la Agencia Española de Protección de Datos (AEPD); Miguel García-Menéndez, Consejero Delegado de la Cátedra "Castroalonso" de Ciberseguridad y Entorno Digital de la Universidad de Oviedo y Daniel Sáez Domingo, Presidente del Hub Español de Gaia-X, moderados por Guillermo Orozco Pardo, Catedrático de Derecho Civil de la Universidad de Granada.

Teresa Sánchez explicó que, desde el punto de vista de la protección de datos, los problemas principales de los espacios de datos se centran en torno a las figuras del encargado y el responsable de tratamiento, aunque hay otros, como la responsabilidad activa, las evaluaciones de impacto, la cooperación, los riegos de reidentificación, la gobernanza, la trazabilidad y la transparencia y los derechos de los interesados. No menos importante es la necesidad de poder asegurar la base jurídica de cada tratamiento y escoger sus fines específicos.

En este contexto, añadió Sánchez, el RGPD es una pauta para la prevención de las consecuencias negativas que una tecnología pueda tener para los derechos y libertades de las personas, debiendo ser considerada como una herramienta generadora de confianza que permita el desarrollo de la economía digital.

Pero para aprovechar su potencial es necesario optimizar la formación de los Delegados de Protección de Datos y difundir la importancia de la cooperación interadministrativa para concienciar sobre la importancia de la protección de datos para las personas.

Miguel García-Menéndez presentó lo que puede considerarse un decálogo de los aspectos a tener en cuenta cuando se trata con estos espacios desde un punto de vista jurídico, desde la consideración de los riesgos a que se exponen, como la ciberseguridad y la generación de Deep fakes, a la necesidad de unos marcos reguladores deberían tener en el centro la preservación del valor que generan las organizaciones.

Daniel Sáez, por su parte, se refirió a las principales características de la estrategia europea del dato, que se basan en esas estructuras que proporcionan confianza y seguridad para la compartición voluntaria entre diversos agentes, de manera homogénea, facilitando su interoperabilidad. Otras características son su compartición controlada; la portabilidad; la interoperabilidad; el acceso y uso de datos; la gobernanza y la regulación sectorial, basada en la regla del dominio. No es un proyecto sencillo, por eso se necesitan reglas y estándares, junto con una convergencia técnica y sin olvidar la importancia de la difusión y concienciación, junto con la experimentación.

En su intervención final, Guillermo Orozco recordó que los juristas han aprendido a ser prudentes y cautelosos, pero también queremos que la IA sea beneficiosa y, en este sentido, recordó a Rodotà, cuando señaló que la política tira hacia la tecnología como instrumento eficiente de gobierno, lo que hace a la sociedad más débil.

ESPACIOS PÚBLICOS DE DATOS E INTELIGENCIA ARTIFICIAL EN LA ADMINISTRACIÓN

Para tratar de la importancia de los datos en el ámbito público, contamos con las intervenciones de Alexander Zlotnik, Subdirector General de Tecnologías de Información del Ministerio de Sanidad, Consumo y Bienestar Social; Bernardo Valdivieso, Secretario Autonómico de Planificación, Información y Transformación Digital de la Comunidad Valenciana y Ernesto Faubel, Jefe del Servicio de Ciudad Inteligente del Ayuntamiento de Valencia, moderados por Rafael Marimón Durá.

Alexander Zlotnik destacó que la propuesta del Reglamento de datos sanitarios es la primera propuesta sobre datos sectoriales reales. En este momento existe un texto de compromiso que se espera que se apruebe hacia marzo de este 2024. Es la primera norma en el mundo que pretende resolver los problemas que intenta resolver, que la recogida de datos por los profesionales les quita tiempo para la asistencia de los pacientes y que los datos son difíciles de acceder y compartir. En este sentido, el Reglamento intenta crear nuevos derechos, como el acceso instantáneo a los datos sanitarios por las personas físicas, facilitando el acceso a ciudadanos y profesionales de un conjunto amplio de información estandarizada y por ello, susceptible de tratamiento.

A continuación, Bernardo Valdivieso, expuso los tres grandes retos a que se enfrentan los espacios de datos: en primer lugar, orientar su actuación al valor, dejando de lado las tareas que no lo aportan; anteponer el cuidado paliativo y personalizar la medicina.

En su caso, el objetivo es desplegar una estrategia digital con el dato en el centro, en una comunidad altamente digitalizada pero dotada de una tecnología obsoleta, no orientada al dato y con datos en formato no interoperable, como es la valenciana. Es decir, resolver la dificultad de dar una respuesta para el uso primario de los datos (y, de rebote, también para el secundario).

En su turno de palabra Ernesto Faubel se ocupó de las ciudades inteligentes basadas en el dato, desde la premisa de que, en estos entornos, el dato generado debe servir para la toma de decisiones. Para ello, el núcleo es una plataforma de ciudad, o conjunto de sistemas inferentes, con varias capas que comienzan por la recogida de datos y pasan por la gestión y distribución de los mismos para su explotación, lo que requiere la disponibilidad de unos cuadros de uso para los diferentes niveles de usuarios (internos o externos). En este contexto y disponiendo de los datos adecuados, la IA puede resultar de utilidad para tareas como el control de la ocupación de los aparcamientos públicos, con una capacidad de predicción de hasta una hora; la coordinación del nodo sur de la UE para Smart cities o la participación en el consorcio europeo de infraestructuras digitales para gemelos digitales y cityverso.

RETOS JURÍDICOS: DE LOS DERECHOS DIGITALES A LA EVALUACIÓN DE IMPACTO EN LOS DERECHOS FUNDAMENTALES. DE LA DPIA AL ALTAI MODEL

Para abordar el alto componente jurídico de la materia objeto de estudio, el encuentro organizó una mesa, segunda de la tarde, en la que participaron Tomás de la Quadra-Salcedo, catedrático emérito de la Universidad Carlos III de Madrid; Rafael Bustos Gisbert, Catedrático de Derecho Constitucional de la Universidad Complutense de Madrid; Ulises Cortés, Investigador y Coordinador Científico del High Performance Artificial Intelligence Group del Barcelona Supercomputing Center - Universitat Politècnica de Catalunya y Pere Simón Castellano, Profesor de Derecho Constitucional de la UNIR.

En su presentación de la mesa, su moderadora, la Catedrática de Derecho Constitucional de la Universitat de València Josefa Ridaura, señaló que la IA puede afectar a los derechos fundamentales de las personas, sobre todo cuando se equivoca o discrimina. Por ello, debemos evitar ir hacia un desarrollo de la IA que nos lleve a zonas de no derecho, ajenas a las sociedades democráticas, utilizando los derechos como cortafuegos frente a la arbitrariedad del poder.

Ulises Cortés, pues este profesor expuso las premisas tecnológicas sobre las que poder desarrollar a continuación el debate jurídico.En este sentido, Cortés comenzó explicando que la finalidad de la IA es estudiar el funcionamiento del cerebro animal y tratar de reproducirlo en un ordenador.

En la actualidad, la IA se puede considerar como una especie de cocktail que combina conceptos como autonomía, racionalidad limitada, machine learning, representación del conocimiento, diferentes formas de sensorización y comunicación y capacidades de diverso tipo. Y aunque los resultados que ofrece en ocasiones pueden parecer magia, no deja de ser la consecuencia de un cálculo probabilístico.

A falta por el momento de una regulación concreta de esta tecnología, es conveniente tener en cuenta las siete características que definen una IA fiable, tal como las presentó en 2019 el Grupo de expertos de alto nivel de la Comisión Europea: intervención y supervisión humanas; robustez y seguridad; privacidad y gestión de datos; transparencia; diversidad, no discriminación y equidad; bienestar social y medioambiental y rendición de cuentas.

Sin embargo, hay que tener en cuenta que, por una parte, que muchos de los datos utilizados para el entrenamiento de la IA proceden de los Estados Unidos y de China, cuyos hábitos y sesgos sociales son diferentes de los nuestros.

Entrando ya en el análisis de las implicaciones jurídicas de esta tecnología, Tomás de la Quadra-Salcedo, en conversación con Ricard Martínez, comenzó poniendo de manifiesto que la IA puede poner en cuestión los derechos fundamentales. Por tanto, el punto de partida, subrayó, debe ser considerar la incidencia de la IA en la conformación de la democracia y del mercado. Hay que tener en cuenta que el desarrollo de la IA está en manos de muy pocas empresas y esta circunstancia puede acabar afectando a la democracia. Y algo similar ocurre con nuevas creaciones como la persona aumentada o las neurotecnologías.

Por todo ello, los derechos fundamentales y, en particular, el artículo 18 de la CE (LA LEY 2500/1978) son el punto de partida: la ley puede limitar el uso de la informática porque la tecnología puede afectar a los derechos fundamentales, un postulado que se ha concretado con la llegada de la IA.

En esta situación, la Carta española de Derechos Digitales (LA LEY 16317/2021) plantea una relectura digital de los derechos fundamentales. Y, por su parte, la AI Act se presenta como una norma abierta que se remite a otras, como el RGPD, y a su desarrollo por la Comisión europea, lo que implica su dificultad para regularla de forma integral de acuerdo con el progreso de la técnica.

Avanzando en el análisis, Rafael Bustos señaló que, en estas condiciones, hay que reaccionar normativamente al riesgo. Los cambios tecnológicos no han tenido vuelta atrás y a largo plazo han sido beneficiosos para la humanidad, por lo que el Derecho se ha adaptado a ellos.

Ahora, ante los riesgos que plantea la IA se requiere de una intervención normativa que ha de ser diferente de las anteriores. A este respecto hay que tener en cuenta, destacó, que la llegada de la IA plantea una extraordinaria oportunidad para el desarrollo de los derechos fundamentales, si no se pierden de vista las oportunidades que ofrece. Pero en la actualidad estamos en una actitud defensiva y no proactiva ante esa oportunidad. La pregunta que podríamos hacernos es hasta dónde nos puede ayudar la IA a realizar nuestros deseos.

Un elemento relevante para la protección de los derechos fundamentales ante la IA es la evaluación de impacto, tema del que se ocupó el abogado y profesor Pere Simón. Esta figura se ha configurado en el Reglamento de IA como una obligación que se configura en un requisito horizontal obligatorio del sistema de gestión de riesgos y la necesaria evaluación de conformidad. Se trata de una evaluación que deberá realizarse antes del primer uso del sistema, pero surge la duda de si no se trata de un compliance meramente cosmético, si su exigencia no es continua. En particular, subrayó que sin esa evaluación de impacto no es posible obtener la evaluación de conformidad de los sistemas de IA de alto riesgo. Y esta evaluación supera la basada en el modelo ALTAI.

Simón enumeró los diez componentes clave que debe considerarse al evaluar el impacto en los derechos fundamentales de un sistema de IA: 1. La legitimidad de las fuentes de información y de las bases de datos de las que se nutra el algoritmo; 2. Los actores involucrados; 3. El foro o el contexto de aplicación y los colectivos potencialmente afectados; 4. El evento que impulsó la necesidad de evaluación; 5. La temporalidad del sistema; 6. La accesibilidad del público general; 7. La metodología utilizada; 8. El conjunto de evaluadores; 9. El impacto real del sistema y, 10. La hipotética compensación por los daños que esta pueda causar.

CASO DE USO: IA EN LA JUSTICIA

Trataron este tema Pedro Moya Donate, Letrado de la Justicia de la Generalitat Valenciana; Gustavo Martín Martín, Juez del Juzgado de lo Mercantil nº 1 de Alicante y del Juzgado de Primera Instancia de Marcas de la UE de España; Alfonso Peralta Gutiérrez, Juez y Consultor UNESCO IA - Estado de derecho y Grisel Giunta Santimoteo, Manager Responsable de Justicia en Minsait, moderados por Vicente Pérez Daudí, Catedrático de Derecho Procesal de la Universitat de Barcelona.

En primer lugar, y desde el punto de vista de la industria, Grisel Giunta se refirió a la potencialidad y transversalidad de la IA en el ámbito de la Administración de Justicia.

En este sentido, indicó que la AI Act no es la solución, sino el comienzo de un proceso continuo con la idea de que Derecho y tecnología vayan de la mano, ayudando en tareas como la revisión de documentos, la identificación de elementos legales y jurisprudenciales y el análisis predictivo. Se trata de implementar soluciones innovadoras ante tareas complejas para incrementar la eficiencia.

A continuación, Pedro Moya presentó la situación de la digitalización de la justicia, desde su experiencia en la administración autonómica. El Real Decreto ley 6/2023 (LA LEY 34493/2023) acaba de introducir modificaciones muy profundas en la Administración de Justicia. Pero esta tiene un problema de gestión del cambio pues, para el 31 de diciembre de 2025 tendrán que estar implementadas todas las medidas previstas, incluidas la publicación de las tres leyes de eficiencia, so pena de sufrir una sanción de 835 millones de euros.

La tecnología permite que las aplicaciones puedan evolucionar con mucha sencillez, pero hay que explicarlo bien, pues, además, falta eficiencia organizativa. La realidad es que se está haciendo mucho, pero no se conoce. Por ejemplo, el CTEAJE está trabajando en interoperabilidad de documentos y expedientes, el punto neutro judicial y el tablón edictal judicial único.

En su turno, el magistrado Alfonso Peralta, puso énfasis en que en la práctica jurídica no cuenta el derecho, también importan las herramientas utilizadas. Hay que partir de la base de que todos los procesos de Justicia son mecanizables, por ejemplo, todos los antecedentes de hecho son automatizables. Pero para ello, lo primero es conocer la organización, sus necesidades y debilidades.

En este sentido es importante tener en cuenta que la Justicia es muy rica en datos que se pueden aprovechar para conocer y mejorar. Por ejemplo, se ha constatado que los sistemas de resolución de litigios en línea, o ODR por su abreviatura en inglés, no han funcionado hasta ahora. Por ello, la Carta Ética Europea para el uso de la IA en los sistemas judiciales del CEPEJ, pretende fomentar el uso de herramientas para mejorar la calidad y eficacia de la Justicia.

Cerró este bloque Gustavo Martín quien comenzó por indicar que la IA podría claramente sustituir a los jueces en algunos casos, como las cláusulas suelo y los litigios en masa.

En su opinión, los humanistas tienen que estar en la vanguardia del desarrollo, pero, se pregunta ¿qué incentivos tiene un juez para dedicarse a innovar? Además, surge un problema cuando se piensa que cuando se habla de tecnología en la administración de Justicia, los asesores son personas que llevan años fuera de un juzgado. La realidad es que para llevar adelante esta transformación hacen falta personas que estén en el trabajo diario. Además, el desarrollo de la tecnología está sometido reglas del arte. Y, en este sentido, la aplicación Minerva no cumple los mínimos estándares del CTAJE, a diferencia del sistema Justa, aunque se ha tardado un año en desarrollarse.

RETOS PARA EL DESARROLLO DE LA IA DESDE LA INVESTIGACIÓN

Intervinieron en esta primera sesión de la segunda sesión del congreso, Jesús González Boticario, Catedrático en el área de Ciencias de la Computación e Inteligencia Artificial, en la Escuela Técnica Superior de Ingeniería Informática de la Universidad Nacional de Educación a Distancia (UNED); María de los Llanos Tobarra Abad, Profesora en el Departamento de Sistemas de Comunicación y Control de la Escuela Técnica Superior de Ingeniería Informática de la UNED y Silvia Rueda Pascual, Asesora de Gabinete en el Ministerio de Ciencia e Innovación y Directora de la Unidad de Mujeres y Ciencia, moderados por M.ª Luisa Atienza, Profesora Titular de Derecho Civil de la Universitat de València.

En primer lugar, Jesús González Boticario comenzó recordando que la IA nació para muchas finalidades diferentes, no con un objetivo concreto.

La IA viene para ayudar y a colaborar, para lo que tiene que ser usable y amigable. Y su importancia se derivada del hecho de que quien no utilice el machine learning, no sobrevivirá.

De momento, está sustituyendo, sobre todo, a las personas que trabajan con el conocimiento.

Por eso la IA debe tener en cuenta, desde el diseño, la persona a la que se le va a facilitar (el usuario), al que normalmente no se le tiene en cuenta. Los datos son de las personas y todo el sistema está montado para explotarlos.

Un reto fundamental en el desarrollo de la IA es el de la ciberseguridad. Y a él se refirió Llanos Tobarra indicando, en primer lugar, que estamos en un momento de cambio que obliga a desarrollar nuestra competencia digital.

En la actualidad están aumentando los ataques a los sistemas de IA, orientados, principalmente, a ataques a los datos, consistentes en ataques adversarios y robo o manipulación de datos. También se producen ataques al código, para su manipulación y ataques a la infraestructura, como los ataques de denegación de servicio.

Una adecuada política de ciberseguridad, explicó Tobarra, se basa en tres fases: defensa, ataque y confianza. En la primera, defensa, se aprecian tres momentos: detección, respuesta y prevención. En la fase de ataque hay que considerar que los fenómenos más frecuentes en la actualidad, son la suplantación de personalidad, la distribución de noticias falsas y la automatización y personificación de ataques. Finalmente, hay que destacar que en la fase de confianza, la IA tiene que contar con la seguridad desde el principio, con respeto a la privacidad.

Seguidamente, Silvia Rueda se centró en el muy relevante tema de los sesgos, comenzando por indicar que estos se aprecian en sistemas como los de reconocimiento de voz, que reconocen peor la voz de las mujeres que la de los hombres, porque se dispone de menos datos de ella, o en los sistemas de reconocimiento de imágenes, donde a las mujeres se les suele asignar una herramienta como un secador de pelo, mientras que a los hombres con un martillo. La causa es que la base estadística de los datos que alimentan la IA, potencian los sesgos sociales existentes. Por otra parte, en la actualidad se están generando constantemente contenidos como videos e imágenes sin control. Y frente a ello, hay que recordar que un buen modelo no puede sustituir a unos malos datos, sin olvidar que el problema también está en las personas que desarrollan el software.

FABRICANDO LA INTELIGENCIA ARTIFICIAL

Para abordar los aspectos prácticos del desarrollo de la IA, el encuentro contó con las intervenciones de Jeremy Rollinson, Head of EU Policy, European Government Affairs, Microsoft; Leticia Gómez, Manager Responsable de Estrategia de IA en Minsait y José Pérez, CEO de Woztell, moderados por José Juan Castelló Pastor, Profesor de Derecho Internacional Privado en la Universitat de València

Jeremy Rollinson hizo un repaso de los principales compromisos asumidos por Microsoft para asegurar el desarrollo de una IA fiable, incluyendo los “responsible principles” establecidos por la compañía, que se refieren a la privacidad y la seguridad; la inclusividad; la accountability; la transparencia; la equidad y la responsabilidad. Unos principios que se aplican a las herramientas y procesos, el entrenamiento, las normas y la gobernanza.

En este sentido, las consideraciones clave a tener en cuenta, según Rollinson, son asegurar un enfoque basado en el riesgo; unos requerimientos equilibrados; una alineación con inicativas internacionales y la importancia de la futura Oficina de la IA incluida en la última redacción del Reglamento de IA.

A partir de su experiencia en Minsait, Leticia Gómez, explicó que su empresa estructura esta área en tres niveles: la base analítica, la percepción cognitiva (para aplicaciones de voz y texto) y la IA embrionaria, dedicada a estudiar nuevos casos de uso, como el aprendizaje federado, la computación cuántica o la IA móvil. Como resultado, están potenciando las tecnologías de visión artificial y de IA generativa. La primera la orientan a empresas con mucho activo físico, para actividades de control de seguridad, tanto industrial como laboral; a la protección de la sostenibilidad y de la diversidad y a la inspección visual de calidad o control de cadenas de montaje. En cuanto a la IA generativa, la están orientando a la revisión documental de manuales técnicos industriales; para resolver dudas de clientes y para la transformación de código de una versión anterior de un lenguaje de programación a otro más reciente.

Por su parte José Pérez planteó una intervención basada en la defensa del papel del empresario emprendedor y de sus necesidades en el contexto actual.

“Vengo a pediros que no hagáis leyes”, reclamó, “si no me dejáis trabajar me obligáis a competir con Estados que no respetan las reglas, como empresario tengo que decidir. Y da igual lo que hagáis, el mercado está vivo. No basta con establecer reglas si no ponemos medios para que se cumplan. Rusia tiene teóricamente limitado el comercio, pero sus empresarios pueden seguir haciendo negocios desde otros países. Turquía o rabia tienen prohibido el uso de WhastApp o la voz por IP, pero la población acude a medios alternativos para ello. Si no tenemos esto claro, acabaremos todos siendo clientes de los chinos”.

CASO DE USO: ADMINISTRACIÓN TRIBUTARIA

El segundo de los casos de uso de IA sometidos a debate contó con la intervención de Alberto García Moreno, Profesor de Derecho Financiero y Tributario de la Universidad de Valencia; Ignacio González, de la AEAT; Sonia Díaz Español, Directora General de la Administración Tributaria Valenciana y José Antonio Belso, Catedrático de Economía de la Universidad de Alicante y CEO de Suma Gestión Tributaria, moderados por Eduardo Sánchez, Manager Responsable de Tributos en Minsait.

Alberto García Moreno explicó las diversas utilizaciones de la IA por la Agencia Tributaria, centradas en la actuaciones automatizadas, las resoluciones automatizadas, la investigación y predicción y la elaboración de perfiles, con fines de prevención del fraude.

Esta utilización plantea el problema de la publicidad activa y pasiva de tal utilización, con la particularidad de que por parte de los contribuyentes solo se pueden conocer los sistemas utilizados, pero no, por ejemplo, los criterios de selección de los sujetos a inspeccionar.

Ignacio González explicó por su parte que lo importante en relación con este tema, es saber cuál es el fraude que se pueda haber cometido. Hoy su utilización principal es para ayuda al contribuyente, en forma de un chatbot desarrollado sobre Watson de IBM, o en la gestión del IRPF, para facilitar declaraciones o el cálculo de rendimientos del trabajo o de criptomonedas.

En su experiencia, la IA utilizada por la AEAT sirve para hacer clasificaciones cada vez más precisas por medio de una analítica avanzada, y para descubrir patrones (sin tener en cuenta el dato, solo mediante un criterio topológico de anillos de fraude), debiéndose tener en cuenta, al respecto, que la analítica avanzada no es IA.

A su vez Sonia Díaz señaló que en su administración ya vienen usando la IA tradicional en un chatbot, pero ahora quieren dar el salto a la IA generativa, pues las administraciones están en una carrera por conseguir las mejores herramientas. En su opinión, se pueden publicar las directrices aplicadas por la agencia, pero no las entrañas de la herramienta, para evitar perder el control del fraude. También recalcó la importancia de la transparencia, para que el contribuyente sepa a qué atenerse.

José Antonio Belso explicó la utilización de la IA para el análisis de matriculas de vehículos y para geolocalizar activos tributarios en relación con los impagos de deudas tributarias, el fraude y la prevención de situaciones de impago. También la utilizan para el funcionamiento de un chatbot orientado tanto al cliente (con asistencia humana), como al usuario interno, como un SAC para atender a sus propios operadores.

CASO DE USO: IA EN SALUD

El tercer y último caso de uso estudiado en el congreso estuvo dedicado al uso de la IA en el ámbito de la salud, un tema sobre el que fueron invitados a disertar Julián Isla, de Fundación 29 y miembro del Committee for Orphan Medicinal Products (COMP), de la European Medicines Agency; Juan González-García, PhD Data Science & Biocomputing Unit IACS, Healthcare Data Innovation Council y Leonor Cerdá Alberich, Investigadora en el proyecto EUCAIM (European federated infrastructure for Cancer Images), todos ellos moderados por Ricard Martínez Martínez.

Julián Isla centró su ponencia en el papel y la condición del paciente, poniendo enfasis en la importancia de empoderar al paciente con sus datos, utilizando la IA, que es la mejor “navaja suiza” para el trabajo.

La forma en que se enseña medicina hoy, explicó, es, igual que antes, mirando lo que hace otro. Pero la medicina es más ciencia que artesanía, y para esta tarea a los médicos no se les enseña ni empatía, ni tecnología, ni salud pública. Y ello tiene consecuencias en los pacientes pues al carecer los médicos de esas herramientas, pueden surgir problemas de relación en los caos crónicos y graves. Por otra parte, en muchos casos, los datos médicos están solo en papel, por lo que no se pueden utilizar.

En su turno, Juan González-García explicó su experiencia con el proyecto Healthy Cloud, en el que trabaja. Tal como subrayó, el dato de salud es muy heterogéneo, pues puede proceder de una radiografía, de un análisis de laboratorio o de una prescripción facultativa. Además, cada dato hospitalario se guarda de una forma diferente, de forma fragmentada y sin tener especialmente en cuenta que se tratan de datos sensibles. Por ello, cabe considerar que nos encontramos ante una situación lo más compleja posible.

Finalmente, Leonor Cerdá dio cuenta del proyecto Cancer Image Europe (EUCAIM), una iniciativa puesta en marcha en 2023 que intenta poner en conjunto la gran cantidad de imágenes radiológicas que cada año se generan en un conjunto de hospitales a fin de crear un atlas distribuido de imágenes de cáncer con más de 60 millones de imágenes, y un repositorio federado de datos anonimizados y con metadatos estandarizados. Además, están pensando en desarrollar un gran modelo de lenguaje (LLM) para un mejor control del estado del dato. El problema es que los datos pueden estar en diferentes formatos e idiomas.

CLAUSURA

En el acto de cierre del congreso, María Vicenta Mestre Escrivà, Rectora Magnífica de la Universitat de Valencia celebró la coincidencia de su celebración con el 525º aniversario de la fundación de la Universidad valenciana y subrayó la importancia de mantener una relación segura con la IA.

Por su parte, en sus palabras finales Ricard Martínez destacó que a lo largo de estas jornadas se ha demostrado que España afronta los retos de la IA en la investigación con capacidad, conocimiento, responsabilidad y poniendo a la persona en el centro.

Pero en este proceso entiende fundamental el papel de los poderes públicos y su compromiso con la investigación.

Finalmente, la ministra de Ciencia, Innovación y Universidades, Diana Morant destacó que frente a la necesaria pregunta de qué queremos hacer con la IA hace falta una inteligencia colectiva. El hecho claro a este respecto es que los ciudadanos aprecian el valor de la tecnología, pero también de los riesgos que plantea. Por ello hay que ejercer un liderazgo político sobre las transformaciones tecnológicas sin control. Queremos una IA que responda a las necesidades de las personas, que las entienda y que ofrezca seguridad, destacó.

Para ello la primera clave es una regulación que no frene la innovación sino que la impulse, pero poniendo a las personas en el centro. En este sentido, Morant enfatizó que España lidera a nivel mundial una digitalización humanística. Contamos con una potente infraestructura tecnológica y también con capacidad de supercomputación, por eso hay que desarrollar la colaboración público-privada en I+D+i para conectar son las necesidades de las empresas y la sociedad.